LSTM

本文共 694 字,大约阅读时间需要 2 分钟。

门控RNN要做的事情就是让神经网络学会决定何时清除状态,而不是手动决定。

引入自循环的巧妙思想,以产生梯度长时间持续流动的路径是初始长短期记忆(long short-term memory,LSTM)模型的核心贡献。其中一个关键扩展是自循环的权重视上下文而定,而不是固定的。门控此自循环(由另一个隐藏单元控制)的权重,累积的时间尺度可以动态地改变。在这种情况下,即使是具有固定参数的LSTM,累积的时间尺度也可以因输入序列而改变,因为时间常数是模型本身的输出。LSTM在无约束手写识别、语音识别、手写生成、机器翻译、为图像生成标题和解析中成功应用。

LSTM可以学习长期以来信息。通过刻意的设计来避免长期依赖问题。记住长期的信息在实践中是LSTM的默认行为,而不需要付出很大代价才能获得。

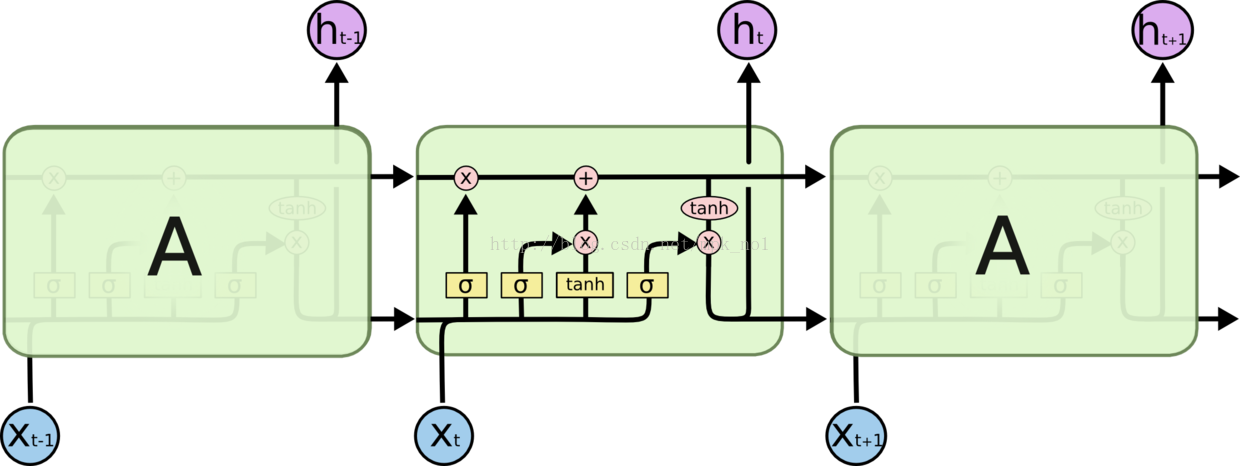

LSTM是这样的结构,但是重复的模块拥有一个不同的结构,不同于单一神经网络,这里有四个,以一种非常特殊的方式进行交互。LSTM拥有三个门结构的特殊网络结构。:

LSTM靠一些门的结构让信息有选择性地影响RNN中每个时刻的状态,所谓门结构就是一个实用sigmoid神经网络和一个按位做乘法的操作,这两个操作结合在一起就是一个门结构。该结构会使用sigmoid作为激活函数的全连接神经网络层会输出一个0到1之间的值,描述当前输入有多少信息量可以通过这个结构。于是这个结构的功能就类似于一扇门,当门打开时(sigmoid输出1),全部信息都可以通过,当门关上时(sigmoid输出为0),任何信息都无法通过。

输入门:

遗忘门:

候选记忆单元:

当前时刻记忆单元:

输出门:

输出:

参考:

- 《深度学习》

你可能感兴趣的文章

CSS基础

查看>>

How to Reset or Change Microsoft Office 2007 Product License Key or Volume License Key (VLK)

查看>>

使用java concurrent调用xmlp api生成pdf

查看>>

这个sql咋写?

查看>>

SQL to inspect form personalization

查看>>

A Simple Example of Weak Ref Cursor

查看>>

trap or bug when using CONTINUE in Oracle 11g

查看>>

Oracle之AUTHID CURRENT_USER

查看>>

Oracle之NULL IS NULL

查看>>

Oracle日期计算之INTERVAL

查看>>

Oracle PL/SQL之EXCEPTION

查看>>

Oracle PL/SQL之EXCEPTION -- WHEN OTHERS THEN

查看>>

Oracle PL/SQL之VARCHAR2 QUALIFIER

查看>>

Oracle PL/SQL之处理index不连续的table类型变量

查看>>

Oracle PL/SQL之嵌套表(Nested Table)

查看>>

Oracle PL/SQL之令人不解的提示(nls_date_format)

查看>>

Oracle PL/SQL之GROUP BY ROLLUP

查看>>

Oracle PL/SQL之GROUP BY CUBE

查看>>

Oracle PL/SQL之GROUPING 函数

查看>>

Oracle PL/SQL之GROUP BY GROUPING SETS

查看>>